Néhány hónapja még 98%-os pontossággal oldott meg egy egyszerű matematikai feladatot a ChatGPT, ma már csak 2%-osan. Mi az ördög történhetett?

Az egyik legismertebb nyelvi modellező mesterséges intelligencia, a ChatGPT a Stanford Egyetem tanulmánya szerint júniusban rosszabbul teljesített bizonyos feladatokban, mint a márciusi verziója.

Az egyetem több hónapon keresztül vizsgálta az OpenAI chatbotját feladattípus szerint: matematika, kódolás, vizuális gondolkodás, szenzitív kérdések megválaszolása. A kutatók két változatot (GPT–3.5 és GPT–4) vizsgáltak az adott időszakban, és nagy ingadozásokat – a zsargonban drifteket – találtak az egyes feladatok elvégzésében.

A legsúlyosabb eredményeket a GPT–4 matematikai képességei hozták.

A prímszámok meghatározását márciusban 97,6 százalékos pontossággal végezte, három hónappal később ez visszaesett 2,4 százalékra. Ez brutális visszaesés, ám ugyanebben az időszakban a GPT-3.5 pont ellentétes pályát futott be: ugyanazt a feladatot márciusban 7,4 százalékos, júniusban 86,8 százalékos pontossággal oldotta meg.

Hasonlóan ingadozó eredmények születtek akkor is, amikor a kutatók kód írására kérték az egyes változatokat, vagy vizuális gondolkodási tesztet végeztek, ami arra kérte a szoftvert, hogy jósolja meg a következő ábrát egy mintában.

A változás mértéke váratlanul érte „a kifinomult ChatGPT-t”, jelentette ki James Zou, a Stanford IT professzora, a tanulmány egyik szerzője. A kutatók szerint az eltérő eredmények nem annyira a modell pontosságát tükrözik a feladatoknál, inkább azt, hogy a modell egyik részén végzett változtatások kiszámíthatatlan hatással vannak a többi részre.

Ezen kívül próbálják a ChatGPT-t „domesztikálni”, azaz megelőzni, hogy „veszélyes kérdésekre” válaszoljon, ami szintén hatással lehet más területekre is.

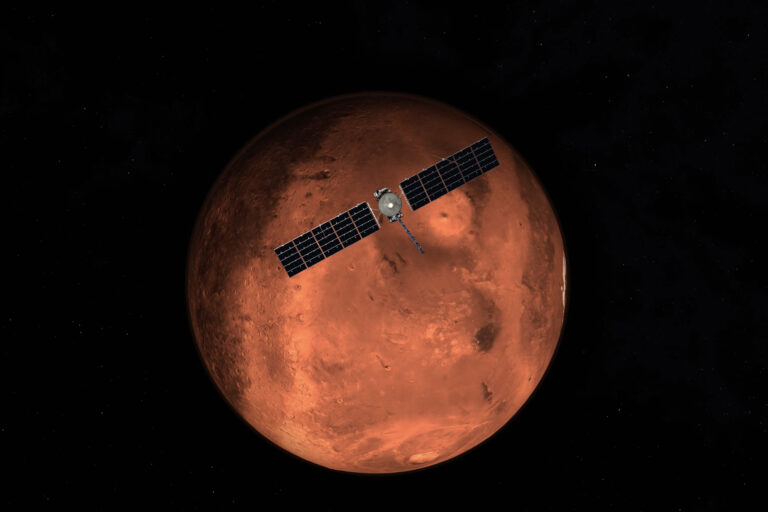

(Forrás: Fortune, fotó: Sam Altman, az OpenAI CEO-ja egy előadáson – GettyImages)

Ez is érdekelhet: